KIs sind das Produkt ihrer Umgebung

Im Beitrag stellen sich Raphael Luz Y Graf und Marco Müller die Frage, ob uns die intelligenten Maschinen in Zukunft gefährlich werden können.

Die Computerzeitschrift „Wired“ titelte im Februar 2017: „DeepMind's AI has learnt to become 'highly aggressive' when it feels like it's going to lose“. Dabei bezogen sie sich auf eine Studie, in der Forscher von Google das Verhalten einer KI in verschiedenen sozialen Dilemmata untersuchten. Unter einem Dilemma versteht man eine Situation, in der für mehrere Personen eine Zusammenarbeit die beste Lösung wäre, egoistisches Handeln jedoch besser erscheint.

Die Entwickler von Googles „DeepMind“ - einem KI-System, das auch gelernt hat, die weltbesten Go-Spieler zu schlagen – wollten untersuchen, wie es sich in sozialen Dilemmata verhält. Da die Autoren einen besonderen Fokus darauflegen wollten, wie es sich die verschiedenen Strategien aneignet, entwarfen sie zwei eigene Spiele: „Gathering“, und „Wolfpack“.

Im ersten Spiel geht es für die Spieler – die alle von DeepMind gesteuert werden – darum, Äpfel zu sammeln. Wenn einer aufgenommen wurde, taucht nach einer bestimmten Zeit ein neuer Apfel auf. Allerdings haben die Spieler noch eine zweite Handlungsoption. Sie können mit einem Laserstrahl auf den Gegenspieler schießen. Daraufhin kann der Gegner für eine bestimmte Zeit nichts tun. Die Teilnehmer müssen also abwägen: „Hilft es mir mehr, meinem Gegner zu schaden oder sollte ich versuchen, mit ihm zu koexistieren?“.

Die Forscher simulierten das Spiel mit verschiedenen KI-Modellen und machten einige Beobachtungen. Sofern es genug Äpfel für alle gab, blieben die Spieler friedlich. Sobald sie knapper wurden, verwendeten die Spieler häufiger den Laserstrahl. Interessanterweise lernten die komplexeren (oder vereinfacht gesagt: „schlaueren“) Modelle schneller, den Gegner anzugreifen. Diese Beobachtung sorgte für die eingangs erwähnte Schlagzeile. Und sie ließ uns die zugegebenermaßen steile These aufzustellen, ob intelligente Maschinen die Welt bedrohen. Um das untersuchen zu können, muss man verstehen, wie die KI sich das Spiel beigebracht hat, das sogenannte „Reinforcement Learning“. Was ist das eigentlich?

Lernen durch Verstärkung

Bei „klassischen“ Machine-Learning-Verfahren wie Klassifizierungen besteht die Aufgabe darin, eine Abbildung von Eingabedaten zu Ausgabedaten zu bestimmen. Hierzu gibt es eine Vielzahl an Beispielen: Bilder von Katzen und Hunden sollen etwa Katzen und Hunden zugeordnet werden. Zur Bewältigung solcher Aufgaben sind Trainingsdaten zwingend notwendig. Das heißt, es müssen angelehnt an das obige Beispiel, genügend Bilder von Katzen und Hunden vorhanden sein, die mit korrekter Zuordnung als Katze oder Hund versehen sind. Anhand dieser Daten approximiert das Verfahren eine Abbildung und ist bei breiter Streuung der Daten, passendem Algorithmus und sorgfältiger Parametrisierung in der Lage, eine hinreichend gute Zuordnung der Daten auch von unbekannten Bildern zu ermöglichen.

Anders ist die Lage beim Lernen durch Verstärkung (Reinforcement Learning). Dabei handelt es sich um Machine-Learning-Verfahren, die völlig ohne Trainingsdaten auskommen und ihre Daten anhand der eigenen Interaktion mit ihrer Umwelt erzeugen. Ein sogenannter Agent probiert durch Versuch und Irrtum zu ermitteln, welche Aktion in einer bestimmten Situation am besten ist. Daraus entwickelt er Strategien, um maximale Belohnung zu erhalten.

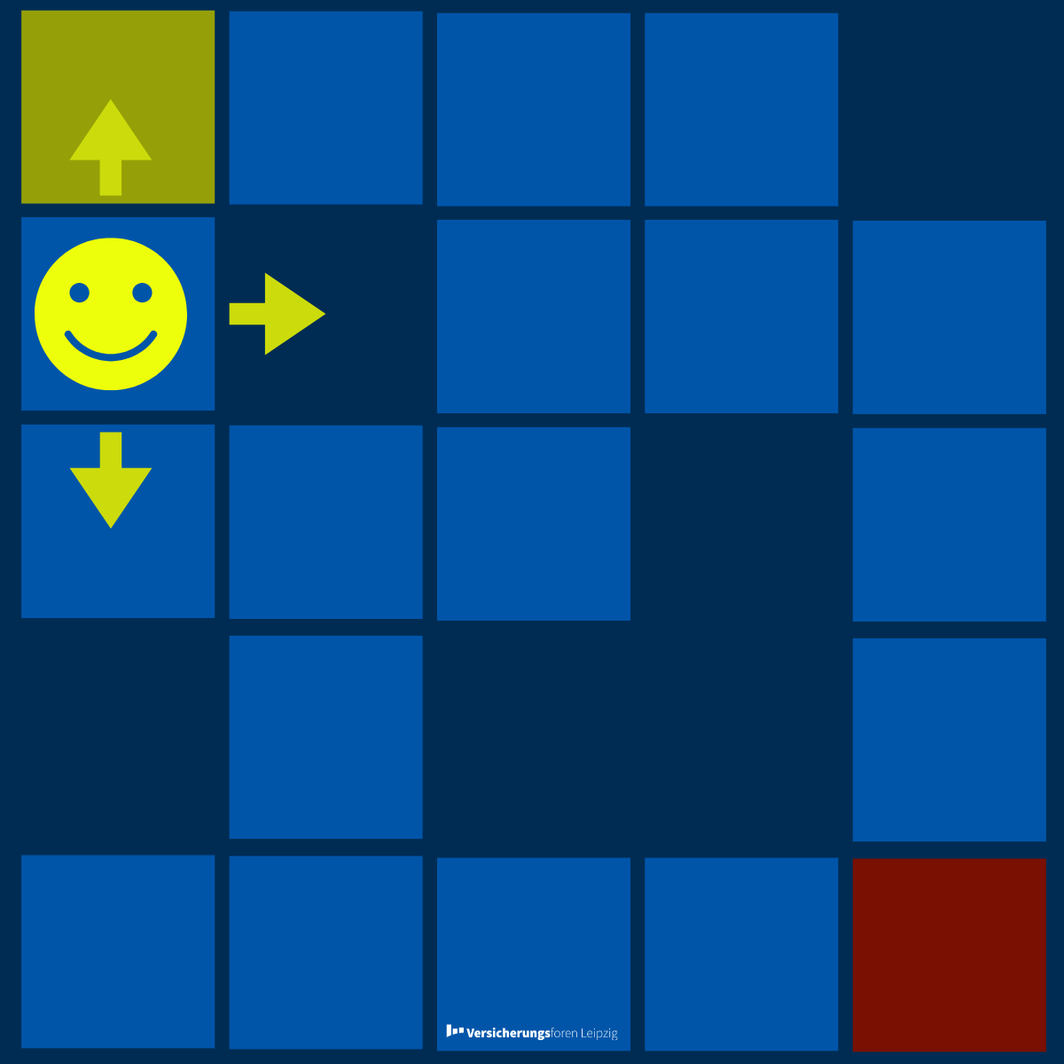

An dem Beispiel eines Labyrinths, in dem ein Agent einen Weg vom Start zum Ziel finden soll, versuchen wir dieses Vorgehen detaillierter zu erklären. Der Agent hat in einer Umgebung dabei festgelegte Interaktionsmöglichkeiten (gehe nach – {oben, unten, links, rechts}). Die Umgebung liefert dem Agenten den aktuellen Status des Spiels zurück, wie "wo befinde ich mich". Zusätzlich erhält der Agent nach jeder Interaktion auch eine Belohnung. Für die Erreichung des Ziels erhält er zehn Punkte und auf allen anderen Feldern Null Punkte. Der Agent kann nun zwischen den einzelnen Interaktionsmöglichkeiten wählen.

Entscheidet sich der Agent im Beispiel nach rechts oder nach links zu gehen, verändert sich sein Status nicht. Er befindet sich immer noch an derselben Stelle, da er schwarze Felder nicht passieren und das Spielfeld nicht verlassen kann. Seine Belohnung ist Null. Entscheidet er sich für „nach unten“, ändert sich sein Status und erhält ebenfalls eine Belohnung von Null. Geht er aber „nach oben“ ändert sich ebenfalls sein Status und erhält er zehn Punkte. Da der Agent das Ziel hat, seine Belohnung zu maximieren, wird er an diesem Status der Umgebung immer nach oben gehen. Dieses Vorgehen wurde hier lediglich vereinfacht dargestellt. Dem interessierten Leser empfehlen wir hier eine Internetrecherche nach Value-Iteration Verfahren, Q-Learning oder auch Deep-Q-Learning.

Wie kann man nun das obige Beispiel auch anderes interpretieren?

Eine KI als aggressiv zu bezeichnen ist ein guter Weg, um Interesse an dieser Studie zu generieren. Unserer Meinung nach ist es aber etwas irreführend. Der Agent ist nicht per se aggressiv, sondern hat lediglich versucht, die in den gegebenen Umständen optimale Strategie zu erlernen. Wenn bei „Gathering“ nur selten neue Äpfel erscheinen und ein Treffer des Gegners ihn lange außer Gefecht setzt, wird der Laserstrahl häufig benutzt.

Anstatt der KI bestimmte Werte zuzuschreiben, ist es sinnvoll, sich die Spielregeln näher anzuschauen. Wenn es Äpfel im Überfluss gibt, ist der Laser bei „Gathering“ nicht optimal und wird daher kaum eingesetzt. Ein noch besseres Beispiel ist „Wolfpack“, das zweite Spiel der Studie. Hierbei spielen die Agenten Wölfe, die einem Tier hinterherjagen. Wenn ein Wolf sein Opfer allein erwischt, verliert er einen Teil der Beute an Aasfresser. Sobald aber mehrere Wölfe in der Nähe sind, vertreiben die Spieler diese und erhalten eine Belohnung. Die Agenten lernten bei den Simulationen sich entweder gegenseitig zu finden bevor sie auf die Jagd gehen oder vor dem Zuschlagen auf andere Wölfe zu warten. Je komplexer die Agenten waren, umso schneller eigneten sie sich dieses Verhalten an. In ihrem Blogeintrag zur Studie stellen die Forscher richtigerweise fest, dass es stark situationsabhängig ist, ob sich die KIs unterstützen oder gegenseitig sabotieren. Das hat zur Folge, dass man beim Entwickeln einer KI besondere Rücksicht auf die Lernumgebung nehmen sollte.

Obacht bei der Modellierung – Fairness ist ebenso wichtig wie Qualität?

Kurz gesagt bestimmt das Modell die Handlung nicht die KI. Diese findet die beste mögliche Strategie ihre Handlungsmöglichkeiten in der modellierten Welt und setzt diese zielführend ein, um eine maximale Belohnung zu erhalten. Die Technologie birgt enormes Potential, doch auch das Risiko, Ergebnisse und Vorhersagen weniger zu hinterfragen und zu analysieren. Der Modellierer, Mathematiker oder auch Data Scientist bekommt neben dem Dreiklang aus Fachexpertise, Programmierung und Machine-Learning-Kenntnissen eine weitere verantwortungsvolle Aufgabe zugeschrieben. Er muss das Modell bei derartigen Problemen sorgsam gestalten und nicht nur die Erfolgsparameter als Messwert an die Verfahren anlegen, sondern auch auf Fairness achten. Wieso sollte man Fairness bei einem Spiel anwenden, welches Äpfel sammelt? Denken wir nur mal an die Entscheidung, ob jemand versichert wird oder nicht. Ob jemand mehr oder weniger für eine Police bezahlt oder nicht. Gerade Entscheidungen, die in der Interaktion mit Menschen oder auch über Menschen getroffen werden, müssen eine überprüfbare Fairness aufweisen, um unter anderem auch Diskriminierung zu vermeiden. Doch was ist fair und was nicht?

Der Begriff der Fairness im Kontext KI wird national und international ziemlich stark diskutiert. Fairness ist dabei eng verwandt mit Ethik und der Frage nach einer Transparenten und nachvollziehbaren KI. Im Juni 2018 veröffentlichte eine von der EU-Kommission eingesetzte Expertengruppe Leitlinien für eine vertrauenswürdige KI. Diese besagen, dass KI-Systeme sehr nützlich sein können, aber auch Gefahren bezüglich Demokratie, Verteilungsgerechtigkeit, etc. bergen. Ein Weg, diese Gefahren abzumindern, ist laut der Expertengruppe eine vertrauenswürdige KI. Um diesen Titel zu verdienen, muss sie rechtmäßig, ethisch und robust sein. Robust bedeutet, dass es zu keinen unbeabsichtigten Schäden durch die KI kommt. Fairness wird in dem Dokument neben „Achtung der menschlichen Autonomie“, „Schadenverhütung“ und „Erklärbarkeit“ zu den ethischen Grundwerten gezählt. Die Experten weisen auch auf Situationen hin, bei denen ein Risiko für ungerechte Behandlung besteht. Dazu gehören Szenarien, in denen Gruppen betroffen sind, die bereits in der Vergangenheit Diskriminierung erfahren haben, z. B. ethnische Minderheiten oder Menschen mit Behinderungen. Das Macht- und Informationsgefälle zwischen Unternehmern und Verbrauchern ist ebenfalls ein Risiko, dass berücksichtigt werden muss. Anhand dieser ethischen Leitlinien entwickelten die Experten Anforderungen, wie sich eine vertrauenswürdige KI realisieren lässt. Auch die deutsche Bundesregierung hat sich mit dem Thema auseinandergesetzt. Im Rahmen ihrer „Normungsroadmap für künstliche Intelligenz“ identifizierte sie fünf Aspekte (Konsistenz, Neutralität, Genauigkeit, Revidierbarkeit, Repräsentativität), anhand denen sich festmachen lässt, ob eine KI fair ist.

Fazit

Wir haben soziale Dilemmata betrachtet und wie KI-Systeme mit ihnen umgehen. Interessant war dabei, dass komplexere KIs scheinbar aggressiver agieren. Über den technischen Blick auf die Verfahren haben wir gelernt, dass Menschen und KIs gleichermaßen Produkte ihrer Umgebungen sind. Daraus folgt, dass bei der Entwicklung von KIs viel mehr Wert auf die Modellierung der Umgebung gelegt werden sollte. Trotz enormer Möglichkeiten und Potenziale sollte nicht außer Acht gelassen werden, dass KI-Systeme auch Gefahren bergen. Sowohl auf EU- als auch auf Bundesebene setzen sich Experten mit dem Thema auseinander. Es ist wichtig, dass eine einheitliche Definition von Fairness für KI entwickelt wird, an derer man diese messen kann. Die Forschungen zur Erklärbarkeit solcher Systeme werden dabei einen weiteren wichtigen Faktor bilden, sodass KI-Systeme auch bei kritischen Entscheidungen mehr zum Einsatz kommen.

Quellen:

https://www.wired.co.uk/article/artificial-intelligence-social-impact-deepmind

Deep Q-Learning | An Introduction To Deep Reinforcement Learning (analyticsvidhya.com)

Ethics guidelines for trustworthy AI | Shaping Europe’s digital future (europa.eu)

https://www.din.de/resource/blob/772438/6b5ac6680543eff9fe372603514be3e6/normungsroadmap-ki-data.pdf