Rechtskonformer Einsatz von KI in Versicherungsunternehmen: Anforderungen des AI Acts

Wie Versicherer den Einsatz von Künstlicher Intelligenz rechtssicher gestalten und sich mit dem neuen AI Act fit für die Zukunft machen.

Lesezeit: 5 bis 7 Minuten

Inhalte:

- Rechtskonformer Einsatz von KI in Versicherungsunternehmen

- KI-VO

- AI Act

- User Cases in Versicherungen

Die Versicherungswirtschaft gilt als datengetriebene Branche. Künstliche Intelligenz (KI) eröffnet hier enorme Chancen – von der automatisierten Schadenbearbeitung über Betrugserkennung bis hin zur personalisierten Kundenkommunikation. Gleichzeitig bewegen sich Versicherungsunternehmen in einem hochregulierten Umfeld. Der rechtskonforme Einsatz von KI ist daher nicht nur eine Frage der Technik, sondern eine zentrale Governance-Aufgabe. Der Beitrag zeigt auf, welche rechtlichen Rahmenbedingungen zu beachten sind, wie Versicherer eine tragfähige Compliance-Struktur aufbauen können und welche praktischen Anwendungsfelder bereits heute im Fokus stehen.

Rechtskonformer Einsatz von KI in Versicherungsunternehmen

Schon heute sind Versicherer verpflichtet, den Einsatz von KI im Rahmen der bestehenden Rechtsordnung abzusichern. Die Datenschutz-Grundverordnung (DSGVO) bildet dabei den zentralen Rahmen. Sie verlangt, dass jede Datenverarbeitung auf einer rechtlichen Grundlage beruht, die Betroffenen umfassend informiert werden und gegebenenfalls eine Datenschutz-Folgenabschätzung durchgeführt wird. Besonders relevant ist dies bei sensiblen Kundendaten, die in vielen Versicherungsprozessen unvermeidbar sind.

Ergänzend fordert das Versicherungsaufsichtsrecht, dass Unternehmen ihre IT-Strategie und ihr Risikomanagement so ausrichten, dass auch KI-Systeme darin integriert sind. Die BaFin erwartet, dass die Modelle transparent, überprüfbar und in die Governance-Strukturen des Hauses eingebunden sind. Ein interner Kontrollrahmen für KI ist also bereits heute keine Kür, sondern Pflicht.

Anforderungen des AI Acts

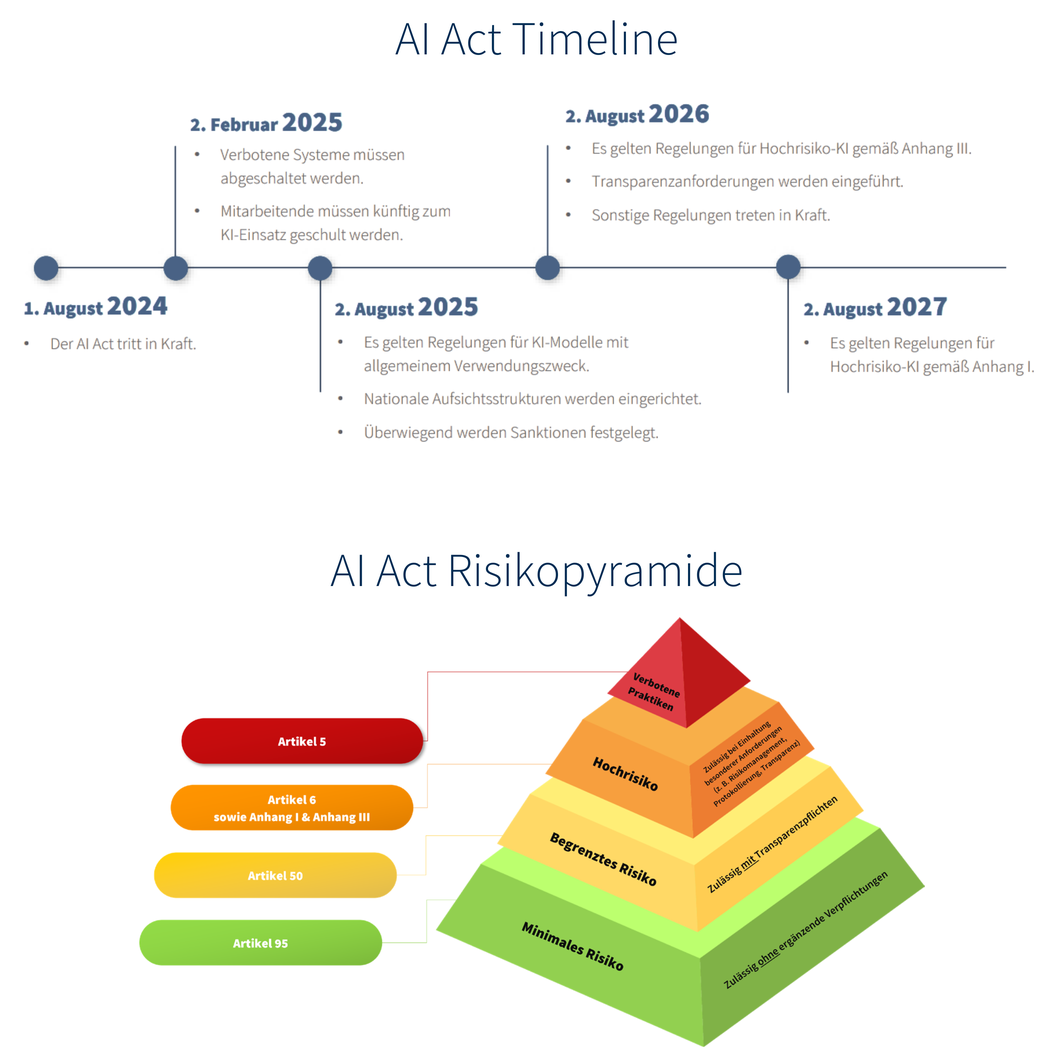

Mit dem europäischen Artificial Intelligence Act (AI Act), der im August 2024 in Kraft trat und ab 2025 zeitlich gestaffelte Umsetzungsvorgaben vorsieht, steht erstmals ein umfassender Rechtsrahmen für den Umgang mit KI-Systemen bereit. Für Versicherungsunternehmen stellt sich damit die Frage: Wie kann KI rechtskonform eingesetzt werden – und welche Pflichten sind zu beachten?

Der AI Act folgt einem risikobasierten Ansatz. Das bedeutet, dass KI je nach Risiko und Einsatzbereich in verschiedene Kategorien eingestuft wird, woraus sich unterschiedliche Pflichten ergeben.

- Systeme mit unvertretbarem Risiko sind vollständig verboten, etwa manipulative KI, die das Verhalten von Kunden massiv beeinflusst.

- Hochrisiko-Anwendungen wie KI-gestützte Risikoprüfungen oder Bonitätsbewertungen unterliegen strengen Anforderungen an Datenqualität, Dokumentation und menschliche Aufsicht.

- Systeme mit begrenztem Risiko, beispielsweise Chatbots im Kundenservice, sind vor allem an Transparenzpflichten gebunden – Nutzer müssen erkennen können, dass sie mit einer Maschine interagieren.

- Anwendungen mit minimalem Risiko, etwa Spamfilter oder KI-gestützte Rechtschreibkorrekturen, unterliegen keinen zusätzlichen Pflichten.

Dieses Stufenmodell schafft Verhältnismäßigkeit und sorgt dafür, dass Regulierung dort ansetzt, wo Risiken für Kunden, Märkte oder Grundrechte am größten sind.

Umsetzungsfristen nach dem AI Act

Erste Bestimmungen gelten ab dem 2. Februar 2025: das Verbot bestimmter Praktiken sowie das Erfordernis von KI-Kompetenz. Zu den verbotenen Praktiken gehören manipulative Anwendungen, die das Verhalten von Kunden erheblich beeinflussen, oder diskriminierende Systeme. Versicherer müssen ihre KI-Anwendungen regelmäßig prüfen und gegebenenfalls anpassen – insbesondere solche, die manipulatives Verhalten fördern oder Social Scoring betreiben.

Parallel dazu rückt die Kompetenzfrage in den Fokus. Mitarbeitende, die mit KI-Systemen arbeiten, müssen über ausreichende Kenntnisse verfügen, um Funktionsweisen zu verstehen, Risiken einzuschätzen und bei Bedarf korrigierend einzugreifen. Versicherer müssen daher Schulungsstrukturen schaffen. Die Aus- und Weiterbildung im Bereich KI wird somit zu einer regulatorischen Notwendigkeit.

Ab dem 2. August 2025 gelten besonderen Anforderungen an Anbieter von Basismodellen – sogenannten General-Purpose-KI-Systeme. Versicherer nutzen diese häufig indirekt, etwa über Sprach- oder Bilderkennungssysteme großer Tech-Anbieter. Auch wenn die Hauptpflichten bei den Anbietern liegen, müssen Versicherer als Nutzer sicherstellen, dass ihre Partner die gesetzlichen Anforderungen erfüllen. Compliance wird somit auch zur Lieferkettenaufgabe.

Die entscheidende Zäsur markiert der August 2026. Ab dann gelten die umfassenden Regelungen des AI Acts, insbesondere für Hochrisiko-KI. Viele typische Versicherungsanwendungen – etwa Systeme zur Risikoprüfung oder Bonitätsbewertung – fallen darunter. Es müssen dann ein durchgängiges Risikomanagement, qualitätsgesicherte und unvoreingenommene Daten, umfangreiche Dokumentationen sowie menschliche Aufsicht gewährleistet sein. KI darf also nicht allein darüber entscheiden, ob ein Kunde eine Police erhält oder ein Schaden reguliert wird – der Mensch bleibt im Zentrum der Verantwortung.

Praxisbeispiele

In der Schadenbearbeitung setzen Versicherer zunehmend Bilderkennungssoftware ein, die Unfallfotos automatisch analysiert. Damit solche Systeme rechtskonform arbeiten, müssen sie technisch zuverlässig sein und regelmäßig auf Verzerrungen geprüft werden. Außerdem muss ein Sachbearbeiter die Ergebnisse plausibilisieren können.

Ein weiteres Beispiel ist das Underwriting. KI-gestützte Modelle helfen, Risiken schneller zu bewerten und Prämien individueller zu kalkulieren. Wenn die Datengrundlage jedoch bestimmte Gruppen systematisch benachteiligt, entsteht ein rechtliches und ethisches Problem. Der AI Act verlangt hier umfassende Maßnahmen zur Vermeidung von Diskriminierung.

Im Kundenservice werden Chatbots eingesetzt, um einfache Fragen zu beantworten oder Vertragsänderungen einzuleiten. Damit dies rechtskonform geschieht, muss für den Kunden klar erkennbar sein, dass er mit einem automatisierten System spricht, und er muss jederzeit die Möglichkeit haben, zu einem menschlichen Ansprechpartner zu wechseln.

KI-Governance

Die Umsetzung dieser Pflichten erfordert mehr als juristisches Wissen. Versicherer müssen eine KI-Governance etablieren, die technische, organisatorische und rechtliche Aspekte verbindet. Dazu gehören:

- ein zentrales KI-Register aller eingesetzten Systeme,

- klare Verantwortlichkeiten,

- regelmäßige Überprüfungen,

- Schulungsprogramme für Mitarbeitende.

Nur so lässt sich sicherstellen, dass Innovation und Compliance Hand in Hand gehen. Die Herausforderung liegt in der Balance zwischen hohen regulatorischen Anforderungen und der Nutzung technologischer Chancen für effizientere Prozesse, besseren Kundenservice und innovative Produkte.

Fazit

Für Versicherer bedeutet das konkret: KI-Systeme müssen bereits heute datenschutz- und aufsichtsrechtskonform eingesetzt, dokumentiert und überwacht sowie von geschulten Mitarbeitenden begleitet werden. Wer diese Grundlagen jetzt etabliert, ist gut vorbereitet, wenn die zusätzlichen Vorgaben des AI Acts ab 2026 verbindlich greifen.

Der AI Act schafft die Leitplanken – wie erfolgreich die Versicherungsbranche diese nutzt, wird die Zukunft zeigen.

Hinweis: Der Artikel erschien zuerst im Themendossier 17/2025 am 15. September.

Titel: KI, Solvency II und FiDA: Regulatorische Herausforderungen und Chancen für die Assekuranz